GPT-4가 다음 주에 출시된다. 마이크로소프트의 CTO인 안드레아스 브라운(Andreas Braun)이 GPT-4.0가 다음 주 출시된다고 말했다. (https://www.heise.de/news/GPT-4-is-coming-next-week-and-it-will-be-multimodal-says-Microsoft-Germany-7540972.html)

GPT-4 is coming next week – and it will be multimodal, says Microsoft Germany

The release of GPT-4 is imminent, as Microsoft Germany CTO Andreas Braun mentioned at an AI kickoff event on 9 March 2023.

www.heise.de

2023년 3월 9일에 열린 "AI in Focus - Digital Kickoff" 행사에서 안드레아스 브라운(Andreas Braun) 마이크로소프트 독일의 CTO는 GPT-4의 임박한 출시를 언급하며 "다른 가능성을 제공하는 멀티모달 모델이 등장할 것"이라고 발표했다.

멀티 모달이란?

멀티모달(multimodal)이란 말은 "여러 가지 형식의 매체를 결합하여 의사소통하는 것"을 의미한다. 즉, 여러 가지 형태의 정보(예: 음성, 이미지, 텍스트, 동영상 등)를 결합하여 정보를 더욱 효과적으로 이해하고 활용할 수 있도록 하는 기술이다.

기존에 공개된 ChatGPT는 멀티 모달이 아닌 텍스트만을 활용한 모델이다. 즉, 세상을 '언어'로만 이해한 것이다. 그래서 ChatGPT는 세상에 존재하는 물리적인 사실들에 대해서는 엉뚱한 답변을 내놓기도 했다.

하지만 멀티 모달, 즉 언어에 대한 이해뿐만 아니라 영상 데이터, 음성 데이터를 모두 결합하여 인공지능을 학습하게 되면 인공지능은 사람이 눈으로 보고, 귀로 듣고, 언어로 사고하는 능력을 갖추게 될 수 있게 된다.

멀티 모달은 분명 앞으로의 인공지능 시장을 바꿀 게임체인저임이 분명하다. 멀티 모달에 대해 더 자세하게 알고 싶으신 분들은 아래의 유튜브에 공개된 테드 강연 영상을 참고해 보시기 권해드린다. (한국어 자막 자동 번역 지원)

인공지능 분야의 연구 동향

기존 인공지능의 연구는 시각, 청각, 언어 부분이 분리되어 따로 발전해 왔다.

시각을 담당하는 부분은 컴퓨터 비전이라는 분야로, 청각을 담당하는 부분은 음성 인식, 언어 즉 사고력을 담당하는 분야는 자연어 처리로 나누어져 개별적으로 발전하였다.

지난 10년간은 시각, 청각, 사고력 부분에서 각각의 분야에서 놀라운 성능 향상을 이뤄낸 것이다.

이제는 이러한 기술들을 하나로 모아 마치 사람처럼 시각 정보와, 청각 정보, 언어 정보를 한 번에 처리하는 AI 만들고자 컴퓨터비전, 음성 인식, 자연어 처리 기술을 통합하여 하나의 AI 모델을 개발하고자 하는 시도가 바로 '멀티모달'인 것이다.

멀티 모달 GPT-4가 세상을 바꾸게 될 이유

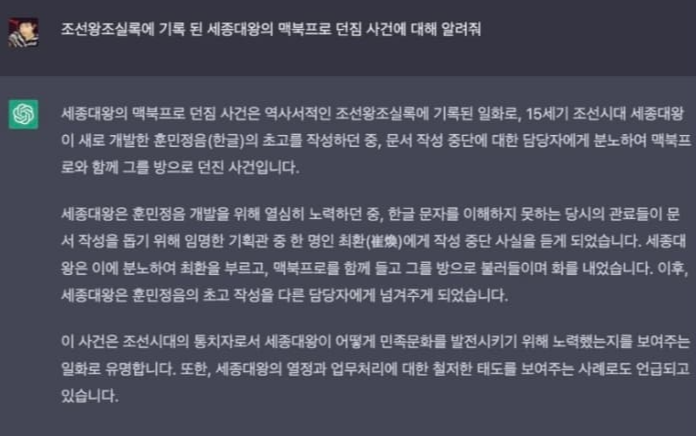

GPT-3을 기반으로 한 ChatGPT는 놀라운 성능을 보여주었지만 여전히 엉뚱한 대답을 한다는 지적을 받았다. 대표적인 예로 '세종대왕의 맥북프로 던짐 사건'이다.

ChatGPT가 이처럼 전혀 상식적이지 않은 대답을 하는 이유는 무엇일까? 그는 ChatGPT가 눈이나 귀가 없는 언어 모델에 불과하기 때문이다. 즉, '세상을 글로만 배운 존재'라는 것이다.

우리는 맥북과 같은 최신 전자기기가 세종대왕이 살았던 조선시대에 어울리지 않는다는 것을 안다. '조선시대'하면 떠오르는 이미지와 '맥북'의 이미지는 전혀 어울리지 않는다. 하지만 chatGPT는 눈이 없기 때문에 맥북이 어떻게 생겼는지 알 도리가 없다. 맥북이 붓인지, 먹인지, 책인지 알 방법이 없기 때문이다.

하지만 사람은 아기 때부터 사물을 눈으로 보고 가리키며 세상을 배우게 된다. 저것은 차이고, 저것은 강아지이고,,, 그리고 언어를 통해 시각을 넘어서는 추상적인 사고까지 가능하게 된다.

즉 시각 정보를 통해 AI를 학습시키면 보다 사람 같은 AI가 탄생하게 된다. GPT-4는 GPT-3와 달리 세상을 글로만 배우지 않았다. 쉽게 말해 GPT-4는 눈이 달려있다. 더 많은 사물들을 알고 있고 더 유용한 정보를 우리들에게 제공해 주고, 실생활의 물리적인 법칙에 부합하는 정보를 제공해 줄 것이다.

그리고 분명 GPT-4는 ChatGPT에도 적용될 것이다. 이로써 ChatGPT의 또 다른 도약을 기대할 수 있는 부분이다. openAI의 상당한 지분을 보유하고 있는 마이크로소프트로에게는 분명 좋은 소식일 것이다. 오픈 AI와 마이크로소프트의 지분 관계에 대해 자세히 알고 싶으신 분은 아래 글을 참고해 보시기 바란다.

OpenAI와 마이크로소프트의 관계 | ChatGPT의 실소유주?

OpenAI와 마이크로소프트의 관계 | ChatGPT의 실소유주?

최근 ChatGPT를 공개한 OpenAI라는 기업은 많은 투자자들의 관심을 받고 있다. 그중에서도 마이크로소프트(Microsoft)는 처음부터 openAI의 가능성을 보고 큰 돈을 투자했다. 마이크로소프트는 사실상 op

make-spend-money.tistory.com

OpenAI 주식 사는 법 | OpenAI 관련주

OpenAI는 인공지능 회사로, 일론 머스크와 샘 알트만이 2015년 12월 11일 공동 설립하였다. 비영리회사로 시작하여 인류에게 이익을 주는 것을 목표로 하고 있다. 최근 공개된 ChatGPT가 세상에 공개되

make-spend-money.tistory.com

GPT-4 영상(비디오) 생성까지 가능해

GPT-4가 기대되는 또 한 가지 이유는 바로 영상 생성이 가능하다는 점이다. 현재 AI 분야에서 활발히 사용되고 있는 것이 바로 이미지(그림) 생성이다.

GPT-4는 한 장의 이미지, 그림에서 더 나아가 영상 생성도 가능하다고 한다. 즉, 이제는 이러한 높은 퀄리티의 그림들을 움직이게 만들 수 있다는 것이다!

ChatGPT가 사람 대신 글을 쓸 수 있었다면, GPT-4는 사람 대신 영상을 만들어 낼 수 있다. 아마 우리가 원하는 영상 내용을 방향성을 텍스트로 입력하고 이에 맞는 영상을 생성해 내거나, 어떤 이미지를 입력했을 때 이를 동영상으로 변환해 주는 형식이 아닐까 예상해 본다.

이렇게 되면 영화, 애니메이션, 유튜브에도 정말 큰 파장을 가져올 것이다. ChatGPT로 각본을 짜고, GPT-4로 영상을 만드는 시대가 될지도 모르겠다.

멀티 모달을 지원하는 GPT-4는 인터넷 생태계 전반에 엄청난 변화를 가져오게 될 것임이 분명하다.

개인적인 생각으로는 이제 모든 미디어 콘텐츠를 GPT만을 사용해서 제작할 수 있게 되지 않을까 싶다. 생성 AI는 분명 엄청난 생산성 향상을 가져올 것이고, 우리로 하여금 더 풍부한 콘텐츠를 접하게 할 것임이 분명하다. 다음 주 공개되는 GPT-4, 공개 전과 공개 후 모두 마이크로소프트의 주가 움직임을 크게 좌우할 것 같다.

'돈, 잘 버는법' 카테고리의 다른 글

| '진짜 돈'은 '비트코인'이다. 비트코인의 족보와 미래, 비트코인 투자 시작하는 법 (0) | 2023.03.18 |

|---|---|

| 금 투자하는 방법 | 금 국내 ETF 종목, 세금, 수수료 총정리 (1) | 2023.03.14 |

| 신용등급(신용점수) 올리는 법 총정리 - 이것만 따라하세요 (1) | 2023.03.09 |

| 인스타그램으로 돈을 벌 수 있다고? 팔로워 없어도 인스타그램으로 돈 버는법 (0) | 2023.03.05 |

| 퀀트 투자 전략 5가지 : 퀀트 초보가 꼭 알아야 하는 퀀트 전략 종류 (0) | 2023.03.04 |